Pourquoi Google a désactivé « num=100 » et ce que cela change pour le SEO ?

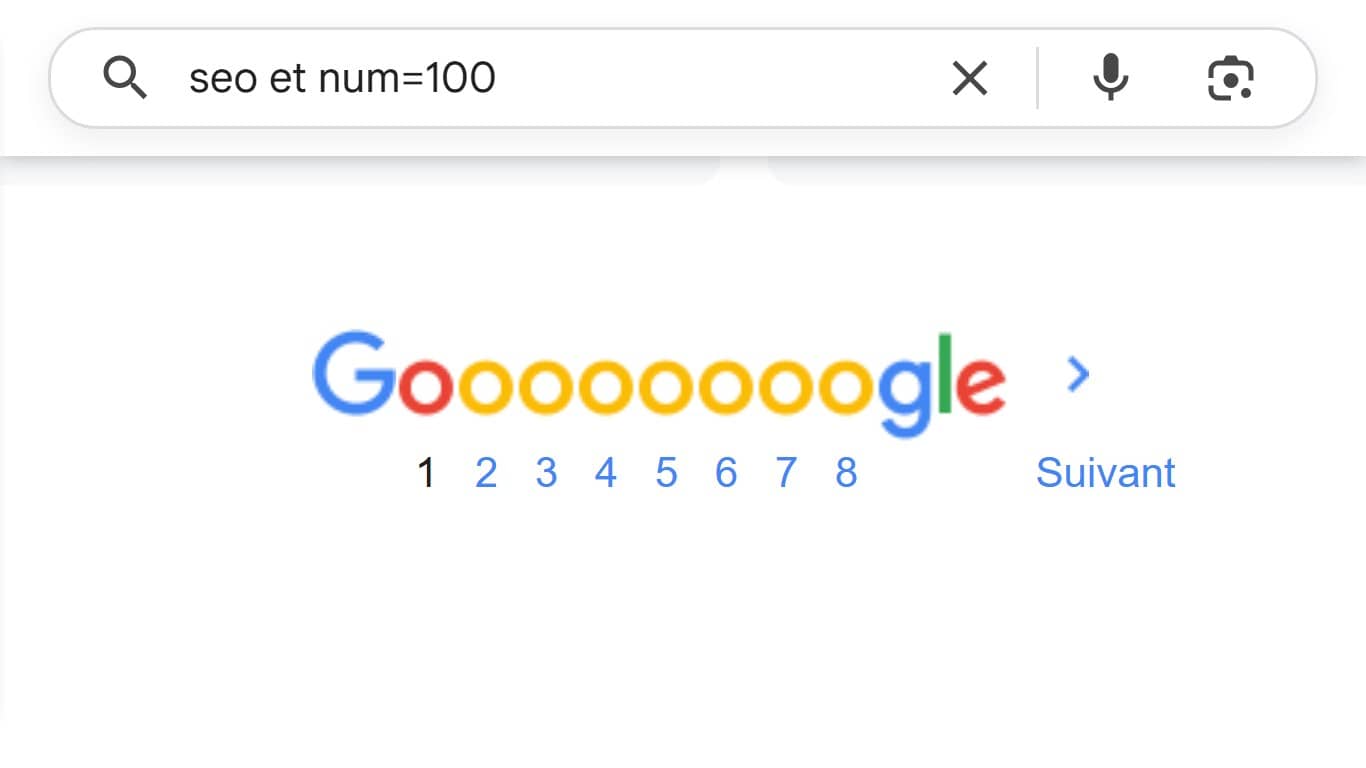

Imaginez que vous passiez des heures à analyser vos positions sur Google pour booster votre site web et améliorer votre contenu, et soudain, un simple paramètre disparaît, rendant vos outils obsolètes. C’est exactement ce qui se passe depuis quelques jours, quand Google a définitivement abandonné le fameux « num=100 », ce code qui permettait d’afficher jusqu’à cent résultats de recherche sur une seule page. Ce changement, survenu sans préavis, n’affecte pas seulement les experts en référencement, mais aussi les internautes ordinaires et les propriétaires de sites qui s’appuient sur des données précises pour comprendre leur audience.

Ce qu'il faut retenir :

- Google supprime num=100 : Ce paramètre, qui affichait 100 résultats de recherche en une page, est désactivé depuis septembre 2025, rendant l’analyse des positions plus laborieuse pour les propriétaires de sites et les experts SEO.

- Le « Grand Découplage » complique les métriques : Les impressions explosent grâce aux résumés IA, mais les clics chutent, faussant les rapports de la Search Console et obligeant à revoir l’interprétation du trafic.

- Visez le top 10 ou 20 : Face à des outils SEO moins précis, concentrez-vous sur les premières positions avec du contenu optimisé pour les extraits mis en avant, afin de capter un trafic qualifié.

- Diversifiez vos approches : Explorez des alternatives comme Bing ou des outils open-source pour compenser la dépendance à Google, et adaptez-vous à un web où l’IA redéfinit les règles.

Qu’est-ce que le paramètre num=100 et comment il influençait l’affichage des SERP?

Pour commencer, le paramètre « num=100 » de Google n’était pas qu’une simple astuce technique, mais un outil, un paramètre supplémentaire, qui permettait d’obtenir un aperçu exhaustif des pages de résultats de moteurs de recherche. En ajoutant simplement « &num=100 » à la fin d’une URL de recherche Google, on forçait l’affichage de cent liens au lieu des habituels dix par page. Cela remontait à des années, bien avant l’ère des recherches assistées par l’intelligence artificielle, et servait de raccourci précieux pour explorer en profondeur les réponses à une requête. Pour les professionnels du web, il représentait une mine d’or : imaginez pouvoir scanner rapidement les cent premiers sites concurrents sans cliquer laborieusement sur plusieurs pages.

Ce mécanisme, discret mais efficace, avait été intégré aux pratiques courantes du référencement naturel, où chaque position compte pour évaluer la concurrence. Sans lui, les SERP redeviennent plus fragmentées, obligeant à une navigation manuelle qui multiplie les efforts. Google, en le supprimant, semble vouloir imposer une expérience plus contrôlée, alignée sur ses algorithmes modernes qui privilégient la pertinence immédiate plutôt que l’abondance brute. Ce n’est pas anodin : pour un site web, cela signifie que les analyses de visibilité se compliquent, car il faut désormais reconstituer manuellement ce que ce paramètre offrait en un clin d’œil. Et si vous pensiez que cela n’impactait que les experts, détrompez-vous ; même un simple curieux cherchant des informations sur un sujet pouvait en profiter pour éviter les clics inutiles.

Pour l’utilisateur ordinaire, quel était l’intérêt de ce paramètre au quotidien ?

Pour l’internaute lambda, loin du monde du SEO, ce petit code était un allié discret qui facilitait la découverte d’informations variées sans se prendre la tête, à condition de le connaître, ce qui était loin d’être le cas pour la majorité des internautes. Pensez à quelqu’un qui tape « meilleures recettes de gâteau au chocolat » dans la barre de recherche : au lieu de se limiter aux dix premières suggestions, souvent dominées par des sites populaires, il pouvait accéder à une vue d’ensemble de cent options en une seule page. Cela encourageait une exploration plus riche, idéale pour comparer des avis, trouver des alternatives locales ou débusquer des pépites cachées au-delà du top immédiat.

Beaucoup ignoraient son existence, mais les habitués, comme les étudiants en recherche ou les amateurs de voyages planifiant un itinéraire, l’utilisaient pour gagner du temps. Sans cela, la navigation redevient plus linéaire, avec des pages qui se chargent une à une, ce qui peut décourager les curieux pressés. Google justifie souvent ces ajustements par une meilleure expérience utilisateur, arguant que les utilisateurs préfèrent des résultats personnalisés et rapides. Pourtant, pour le propriétaire d’un site web modeste, cela pose un vrai dilemme : si les visiteurs ordinaires peinent à accéder à des contenus plus profonds, le trafic organique risque de se concentrer sur les leaders incontestés. En somme, ce paramètre démocratisait l’accès à l’information ; son absence pourrait bien accentuer les inégalités entre les gros acteurs et les petits sites, forçant les seconds à redoubler d’efforts pour se faire remarquer dans un océan de résultats limités.

Un dysfonctionnement imprévisible depuis des mois

Depuis le début de cette année, ce paramètre montrait des signes de faiblesse, oscillant entre efficacité sporadique et échecs complets, ce qui a semé la confusion dans la communauté en ligne. Au lieu de fonctionner de manière stable, il se comportait comme un interrupteur capricieux : parfois, il affichait les cent résultats attendus, d’autres fois, il se limitait aux dix standards, ou pire, déclenchait des vérifications anti-bot inattendues. Des tests rapportés par des observateurs du web indiquaient un taux de succès d’environ 50 %, rendant son utilisation risquée pour les outils automatisés. Cette instabilité n’était pas un bug isolé, mais plutôt le prélude à une refonte plus large des SERP, où Google renforçait ses défenses contre les scrapers et les bots excessifs.

Imaginez vérifier vos classements quotidiens et vous retrouver face à des données incomplètes, simplement parce que le système refusait de coopérer. Cette phase de transition, qui a duré plusieurs mois, a forcé de nombreux à anticiper le pire, en explorant des alternatives comme des API payantes ou des navigateurs personnalisés. Au final, ce comportement erratique n’était qu’un avertissement : Google préparait le terrain pour une suppression totale, confirmée ces derniers jours.

Les répercussions sur les pratiques de référencement naturel

Ce retrait soudain n’est pas anodin, il ébranle les bases du référencement naturel, en rendant plus ardu le suivi des performances et la veille concurrentielle. Pour les agences SEO et les indépendants, qui s’appuyaient sur ce paramètre pour extraire rapidement des données sur les positions des mots-clés, c’est un coup dur : désormais, obtenir les cent premiers résultats nécessite dix requêtes séparées, multipliant par dix le temps et les coûts associés. Des outils populaires comme Semrush ou Ahrefs signalent déjà des ajustements urgents, avec des hausses de prix potentielles pour compenser ces inefficiences. Plus inquiétant encore, la Google Search Console voit ses impressions chuter de manière artificielle pour de nombreux sites, car les anciens pics étaient gonflés par des bots utilisant ce paramètre pour charger massivement des pages. Si vous êtes propriétaire d’un site e-commerce, par exemple, cela pourrait fausser votre vision du trafic organique, vous poussant à sous-estimer votre visibilité réelle.

Le « Grand Découplage » : quand les impressions ne riment plus avec les clics

D’ailleurs, depuis plusieurs semaines, une rumeur enfle dans la communauté du référencement : le « Grand Découplage » (ou « The Great Decoupling » en anglais), un phénomène où les impressions enregistrées dans la Google Search Console s’envolent sans que les clics suivent la même trajectoire. Depuis l’essor des résumés générés par l’intelligence artificielle, comme les AI Overviews, Google affiche souvent des réponses directement en haut des résultats, réduisant le besoin pour l’internaute de visiter un site. Résultat ? Un site peut apparaître des milliers de fois dans les recherches, mais ne générer qu’une poignée de visites.

Google, en mettant fin à ces pratiques, veut freiner les collectes abusives de données, habituellement destinées à entraîner des algorithmes externes. Mais pour le webmaster d’une boutique en ligne ou d’un blog personnel, cette purge complique l’interprétation des performances : vos statistiques semblent moins cohérentes, et évaluer votre visibilité réelle devient un casse-tête. Ce phénomène pousse à revoir ses habitudes, en se tournant vers des métriques plus fiables, comme l’engagement sur les extraits optimisés, pour mieux capter l’attention des visiteurs.

Recentrer ses ambitions : top 10 ou 20 pour les stratégies futures ?

Avec la disparition de ce paramètre, courir après une vue d’ensemble des cent premiers résultats devient une tâche laborieuse et coûteuse. Les spécialistes du web s’accordent désormais sur un conseil : Il vaut mieux se concentrer sur les dix ou vingt premières positions, là où se joue l’essentiel du trafic. Oubliez les analyses exhaustives qui engloutissent du temps et des ressources ; il s’agit maintenant de briller dans les places qui comptent vraiment. Cela demande un changement d’approche : les outils de suivi doivent privilégier des indicateurs précis, comme la force des liens entrants ou la capacité à décrocher une place dans les encadrés spéciaux de Google, ces « snippets » qui attirent les regards. Si vous gérez un site, cela peut signifier : produire des articles ou des pages percutantes, taillées pour des mots-clés stratégiques, plutôt que de surveiller une longue liste de positions secondaires.

Des services comme SEOClarity ou DataForSEO adaptent déjà leurs systèmes, proposant par défaut des analyses limitées aux dix premiers résultats, avec des options payantes pour aller plus loin. Ce recentrage n’est pas une contrainte, mais une chance : en misant sur la qualité, les petits sites peuvent se démarquer dans des niches spécifiques, là où les mots-clés moins disputés offrent une visibilité rapide. Google, avec cette restriction, force le web à privilégier l’excellence sur la quantité, et c’est peut-être l’occasion de polir vos contenus pour viser directement le podium.

L’avenir du web : s’adapter ou se réinventer face aux changements

Ce bouleversement n’est pas qu’une péripétie technique ; il marque un tournant dans la manière dont on navigue et mesure le web. Pour les propriétaires de sites, qu’ils débutent ou maîtrisent déjà leur sujet, il est temps de diversifier ses sources d’information : pourquoi ne pas tester les données de Bing ou explorer des outils communautaires gratuits pour compléter ses analyses ? Les discussions animées, des groupes Reddit aux échanges sur X, révèlent une communauté secouée, mais aussi prête à innover.

Google, en musclant ses barrières contre les abus liés à l’IA, redessine les contours d’un écosystème où la transparence devient un luxe. Pour l’internaute moyen, cela pourrait rendre les recherches plus épurées, avec moins de contenus parasites, mais à court terme, c’est une transition inconfortable. Notre conseil ? Surveillez vos indicateurs clés, comme les taux de clic, et expérimentez de nouvelles méthodes pour analyser votre audience. Ce virage, bien que perturbant, pourrait éliminer des pratiques dépassées et ouvrir la voie à des stratégies plus solides pour faire grandir votre présence en ligne. Une chose est sûre : Google nous réserve encore bien des surprises.

Auteur :

Thierry Chabot

Article publié le

16 septembre 2025 et mis à jour le

16 septembre 2025

Spécialisé en optimisation de site web, audit et corrections des erreurs trop souvent présentes sur les projets clients, je vous accompagne selon vos objectifs et vos besoins.